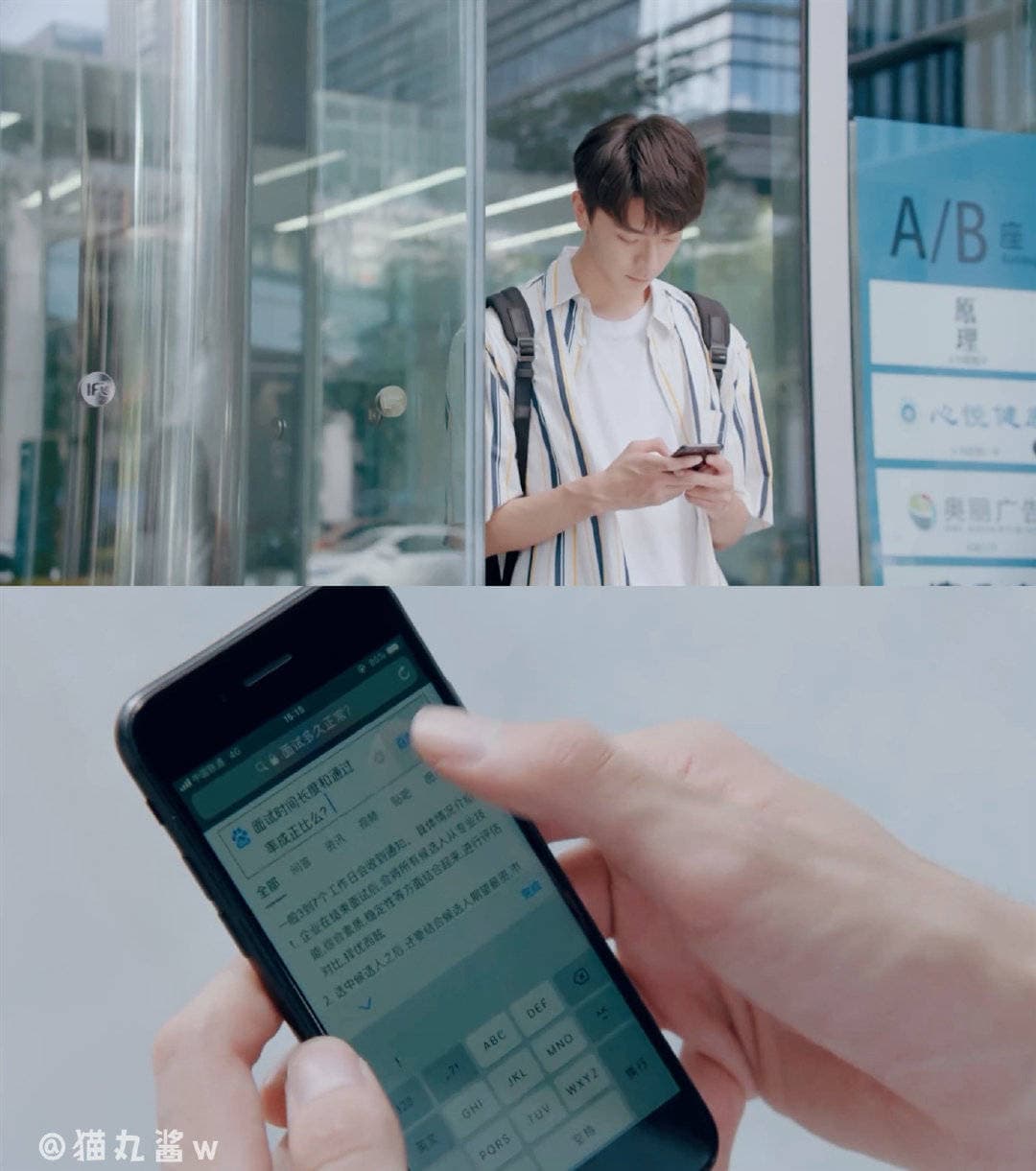

林一拍攝這部的時候才20歲,比劇中年齡還小,所以感情戲很青澀,確實符合顧未易的人設。比較令我驚訝的是,作為他的處女座,竟然一開始就是男一號,很厲害啊!

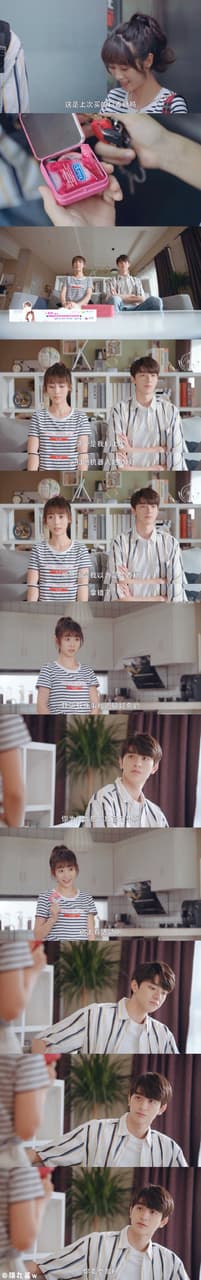

女主刑菲已經25歲了,雖然她娃娃臉看不太出來違和感,但她的口音老是令我出戲。不過兩人確實蠻有CP感,看起來很舒服,最近劇荒,翻出來二刷。

原著跟電視劇裡的傅沛,都是妥妥渣男一枚,但是電視劇幫他漂白了,沒辦法,電視劇有副CP的需求,總不能真的像小說一樣,把王珊演成一個戀愛腦,傅沛是個害人家自殺還不負責的渣渣,那觀眾應該會棄劇。

男配唐曉天在劇中傅沛的人設實在讓我喜歡不起來,加上造型get不到他的帥,以致於他跟刑菲後來二搭的"我的小確幸"雖然評價不錯,但我怎麼也嗑下去。

我覺得這部的改編,比小說更讓我喜歡

貼一篇Dcard分享文

半夜睡不著覺,身為《致我們暖暖的小時光》超級原著黨,怎麼能不發文安利一波呢。